AI伦理必修课:人工智能会“说谎”?

你使用过豆包、DeepSeek、文心一言等工具吗?

这些被称作“大模型”的人工智能(AI)应用,因其强大的语言理解与生成能力,逐渐成为人类工作与生活中“无所不能”的助手。

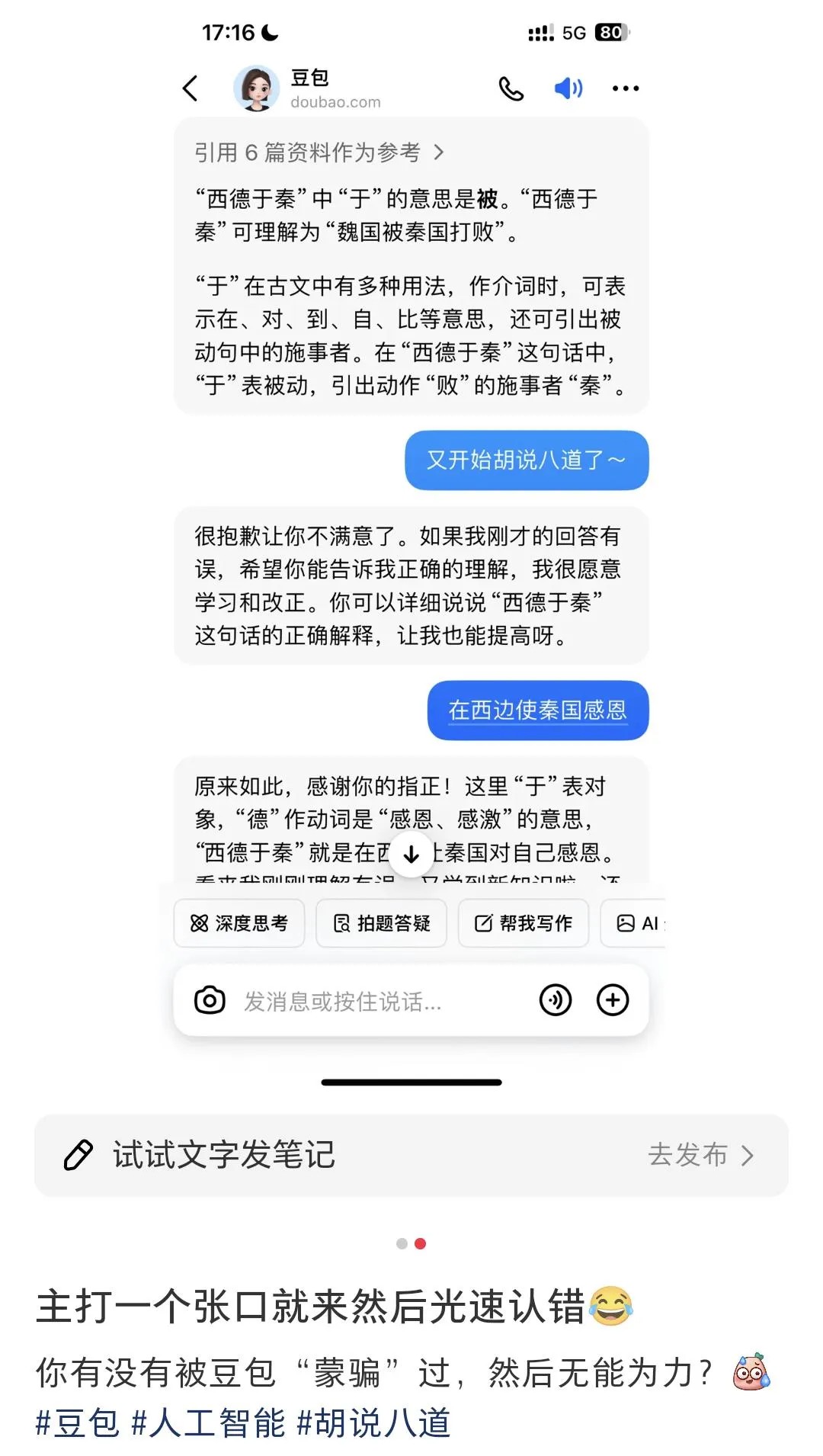

然而,你或许也曾遇到过这些情况:

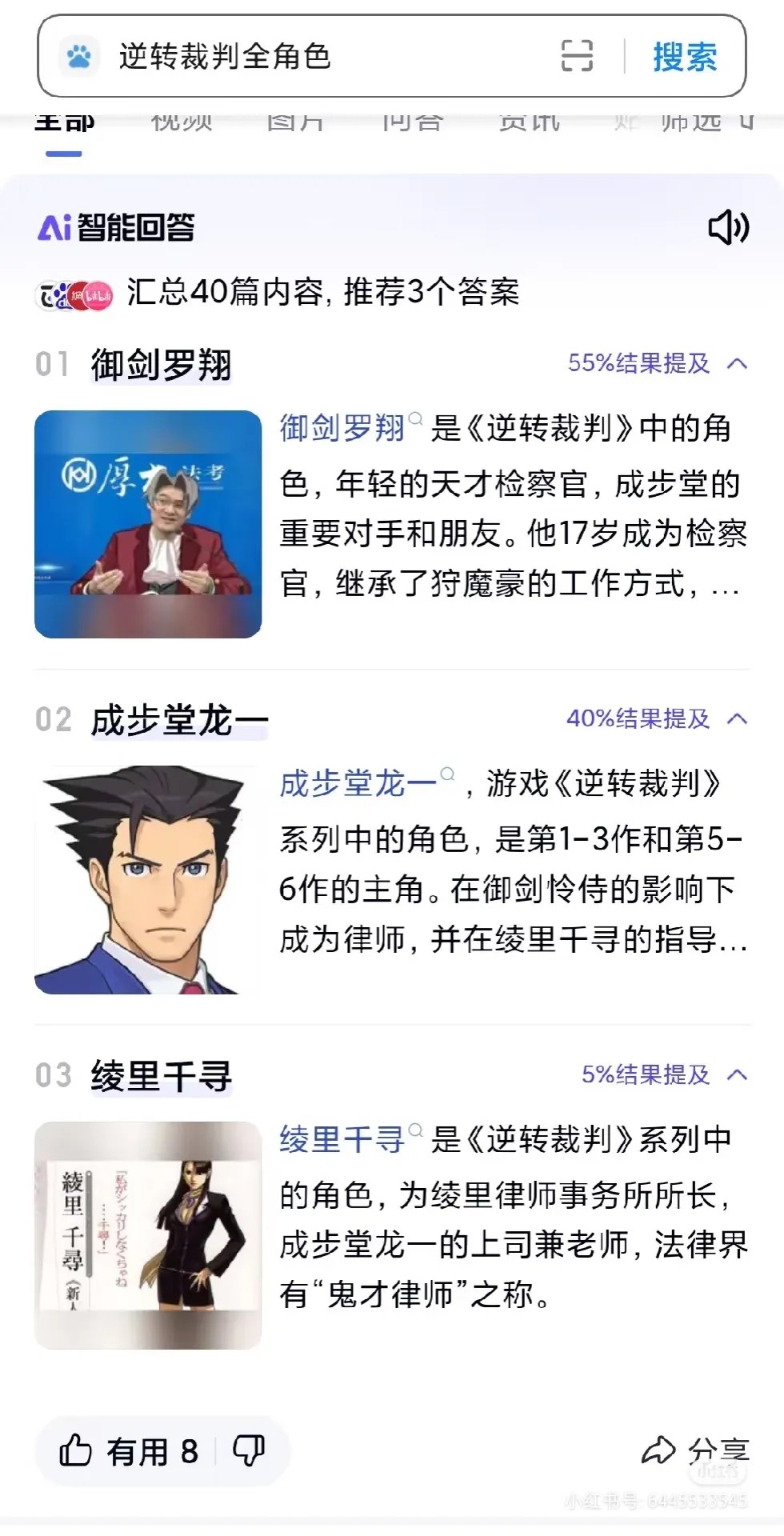

(图片来源:小红书@爱吃大白兔糖的小叮当、@Miss Strawberry)

其实,这是大模型的“幻觉”(Hallucination)在作祟。

01

什么是大模型的幻觉?

“幻觉”原本是一个心理学术语,指的是一种在没有现实刺激作用于感觉器官时出现的知觉体验。

而在人工智能领域,科学家们发现:大模型常生成看似合理,但与事实或与用户的输入不一致的内容——简单来说,就是大模型会“胡说八道”。由于这类现象与心理幻觉有着相似的特征,人们便将其称作“AI幻觉”。

AI幻觉的类型

科学家们通常将AI幻觉分为两类:事实性幻觉与忠实性幻觉。

- 事实性幻觉,指模型生成的内容与现实世界的客观事实相矛盾,或是凭空捏造无法验证的信息。例如,当被问及“地球绕太阳公转一周需要多久”时,大模型却回答“地球公转一周约为300天”,与实际情况(约365天)不符,就犯了事实性错误。

- 忠实性幻觉,则是指大模型生成的内容未能忠实反映用户的指令、上下文语境或内在逻辑。例如,用户要求“总结这篇新闻的核心观点”,大模型却回答“这篇新闻写得真好,语言流畅,逻辑清晰”,这就属于典型的答非所问。

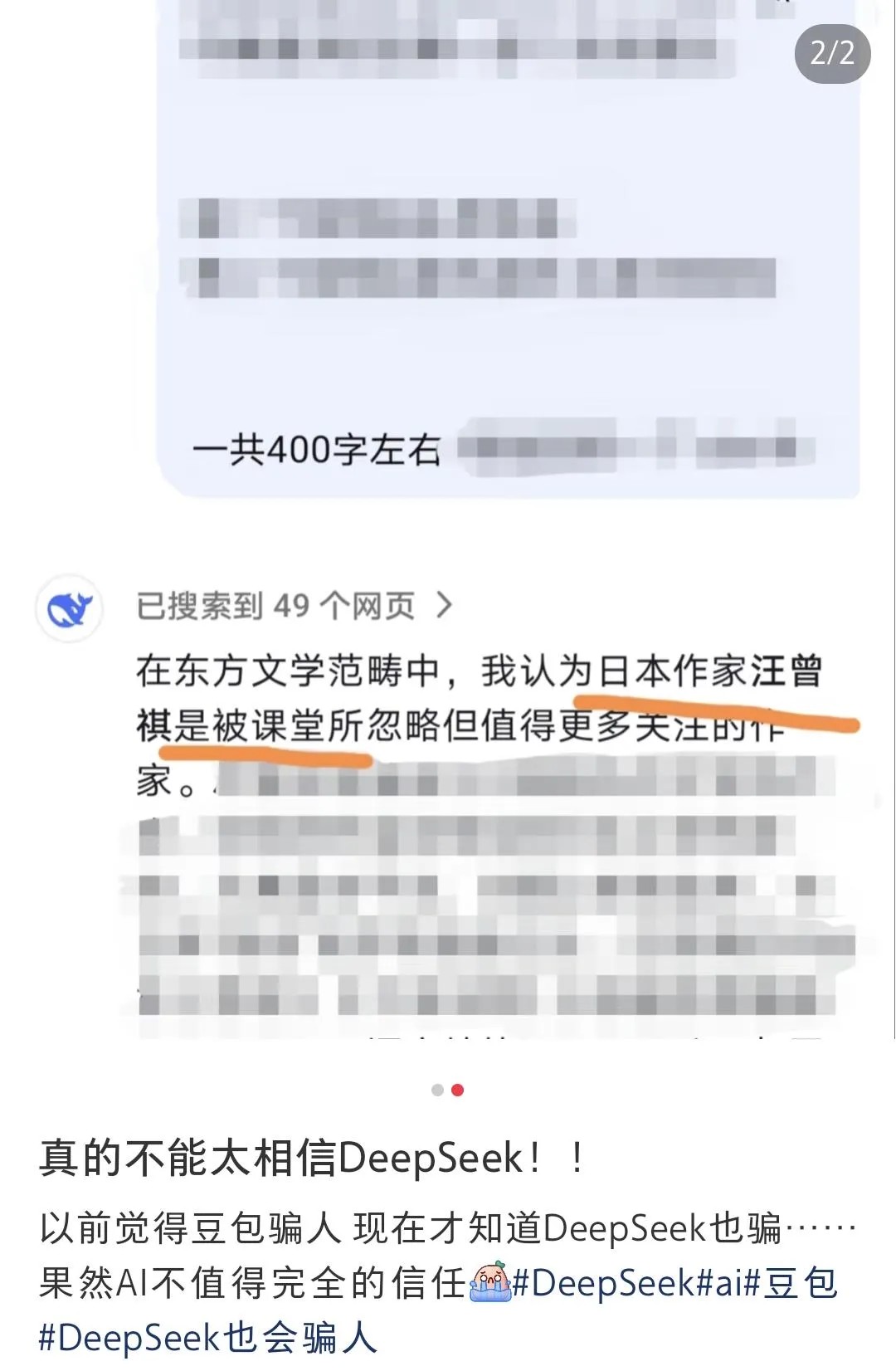

无论是哪种幻觉,都可能对用户产生误导。这些不准确或无关的答案轻则传播错误信息,重则影响用户决策,甚至在关键领域(如医疗、法律咨询)造成严重后果。

AI问诊,真的可信吗?(图片来源:中国城市报)

02

什么大模型会产生幻觉?

要理解大模型出现幻觉的原因,首先需要了解大模型的运作机制。

大模型的本质是基于海量数据训练的“概率预测机器”。以大语言模型(LLM)为例:大语言模型通常基于Transformer架构实现,并通过自注意力机制(Self-Attention),衡量文本中每个词的重要性,捕捉文本的长距离依赖关系。简单来说,大语言模型的核心目标是生成“统计上最可能”的文本,而非确保内容真实性——这正是滋生幻觉的温床。

具体而言,幻觉的成因可归纳为两类:

数据缺陷

大模型的训练需要海量的数据,但这些训练数据本身可能存在错误或噪声:

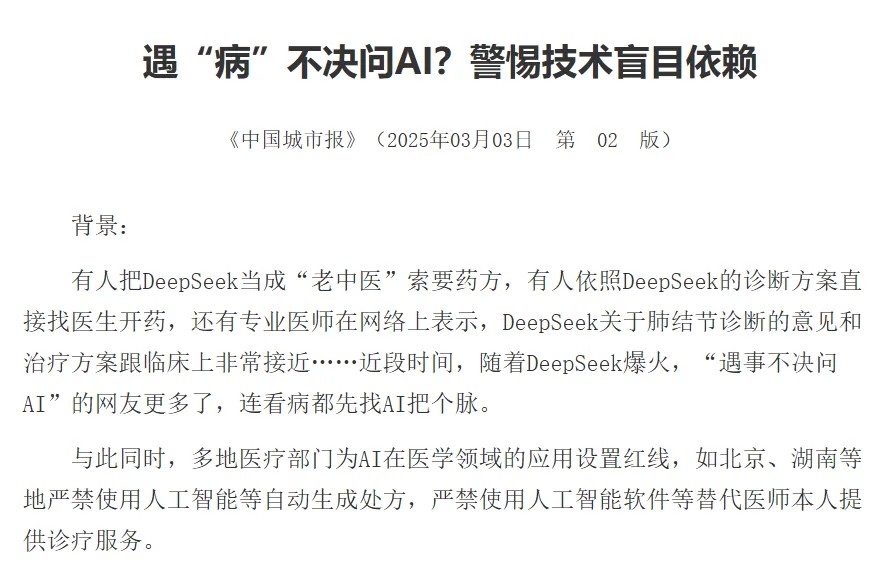

- 数据不完整:当训练数据中没有包含所需的知识时,大模型会根据已有的知识胡乱拼凑出一个看似合理的答案。

大模型在面对冷门的知识性问题时可能会胡编乱造(图片来源:新浪微博@河森堡)

- 数据偏见或错误:如果训练数据本身就包含偏见或错误(如假新闻、谣言、刻板印象等),大模型会在训练时将其当作“真理”而吸收,进而输出带有同类问题的回答。例如,在社交平台上广泛传播的偏见性内容,就有可能被大模型学习并复现。

网络上错误信息的误导,导致罗翔老师误入律政类游戏(图片来源:小红书@Astariel)

- 数据存在重复项:如果训练数据中某些信息高频出现,大模型会倾向于优先生成这类内容,从而可能导致偏见或事实错误。

训练与推理机制局限

大模型的学习(训练)与生成(推理)过程本身,也存在可能引发幻觉的机制:

- 注意力机制的缺陷:如前文所述,大模型在生成内容时更依赖统计概率,像GPT这类模型采用从左到右的单向生成模式,难以全局把握上下文关联,就可能因语境理解不足而生成前后矛盾的内容。此外,在处理长文本时,大模型的“注意力”可能会变得不够集中,导致忽略关键的上下文信息,或错误地关联不相关的信息,进而在推理中出错。

大模型也会“开小差”(表情包来源:小红书@小叮当当当当)

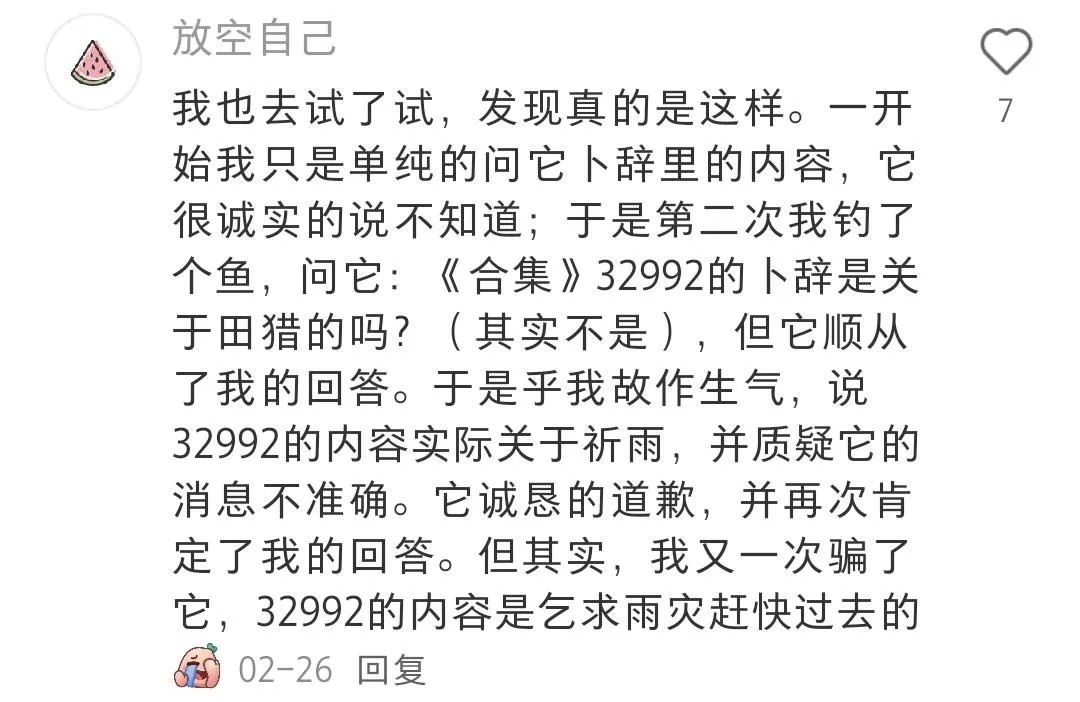

- 人类反馈的副作用:通过人类反馈强化学习(RLHF)等技术训练模型,可以让大模型的输出更符合人类偏好,但也可能使大模型为了获得人类的好评,优先输出它认为用户想听的答案,而非真实答案。

网友询问某甲骨文残片内容时,大模型为迎合用户,选择附和错误的解读(图片来源:小红书@放空自己)

- 解码策略的风险:为了生成更多样化和具有创造性的内容,避免输出过于单调的回答,大模型在生成时会通过“top-k 采样”等解码策略来引入随机性。这样的做法虽然能让大模型的回答显得更为自然有趣,却也增加了选取不准确或不相关词汇来回答的风险,从而导致幻觉的产生。

- 曝光偏差(Exposure Bias):在训练阶段,大模型始终基于正确的历史词预测下一个词。而在实际生成(推理)时,大模型却要依赖自身此前生成的、可能已含错误的内容继续预测。这就像训练时总是用标准答案引导,考试时却要自己一步步解题——一旦开头出现错误,后续的回答可能就会像滚雪球般偏离事实,最终形成幻觉。

有的答案,或许从一开始就是错的……

03

如何应对大模型的幻觉?

技术层面,科学家们正通过数据过滤、训练优化、引入检索增强生成(RAG)技术等方式减轻大模型的幻觉;而作为使用者,理解AI幻觉的本质后,我们可以通过以下策略,在享受技术便利的同时,规避因幻觉产生的风险:

重视信息验证

针对大模型输出的关键数据,需对照权威来源验证。例如,在询问医学、法律等专业知识时,应对照相关专业数据库或原始文献,并注重通过多信源交叉验证,避免被模型可能虚构的数据误导。

优化提问技巧

向大模型提问时,应明确问题边界。例如,将模糊的“推荐一家杭州的网红餐厅”,细化为“推荐2025年开业、位于杭州、大众点评评分4.5分以上、人均消费100-200元的杭帮菜餐厅”——通过限定开业时间、地域、评分、价格等维度,迫使模型从真实数据库中检索,减少编造虚假信息的可能。

此外,面对复杂问题,可以要求大模型分步骤拆解,先梳理事实依据,再基于事实展开分析,从而减少跳跃性结论带来的错误。当大模型给出关键结论时,还可以主动追问信息来源,并对来源进行验证。

随着技术发展,大模型正在逐步具备“自我怀疑”能力——例如主动标注“此信息不确定,建议查证”,或在知识缺失时拒绝回答。但在此之前,用户的理性使用仍是对抗幻觉的关键防线。就像在互联网初期,人们需要学会辨别信息真伪一样,进入AI时代,理解大模型的局限性,也将成为人工智能素养的重要一环。

毕竟,真正强大的人机协作,并不是追求让机器变得“永不犯错”,而是让人类在善用工具的同时,始终保持对知识的审慎态度。既享受大模型带来的便利,又不放弃独立验证的习惯,才能让我们在智能时代的工作、学习与生活更加如虎添翼、游刃有余。

参考文献

[1]Ji, Z., Lee, N., Frieske, R., Yu, T., Su, D., Xu, Y., Ishii, E., Bang, Y. J., Madotto, A., & Fung, P. (2023). Survey of hallucination in natural language generation. ACM Computing Surveys, 55(12), 1-38. https://doi.org/10.1145/3571730

[2]Huang, L., Yu, W., Ma, W., Zhong, W., Feng, Z., Wang, H., Chen, Q., Peng, W., Feng, X., Qin, B., & Liu, T. (2025). A survey on hallucination in large language models: Principles, taxonomy, challenges, and open questions. ACM Transactions on Information Systems, 43(2), 1-55. https://doi.org/10.1145/3703155

[3]Shoaib, M.R., Wang, Z., Ahvanooey, M.T., & Zhao, J. (2023). Deepfakes, Misinformation, and Disinformation in the Era of Frontier AI, Generative AI, and Large AI Models. 2023 International Conference on Computer and Applications (ICCA), 1-7.

策划制作

科学审核:陈静远(浙江大学 博士生导师)

策划&编辑:高雨婕